Que atire a primeira pedra aquele que nunca perdeu seu celular dentro de sua própria casa e depois precisou ligar várias vezes para o próprio número para encontrá-lo. Se depender do Facebook, esta situação pode estar com os dias contados. Pesquisadores de inteligência artificial da rede social sugerem que robôs domésticos podem ser capazes de fazer o trabalho difícil por nós, reagindo a comandos simples como “pegue meu telefone que está tocando”.

Assistentes virtuais como conhecemos são totalmente incapazes de identificar um som específico e usá-lo como ponto de referência. Embora você possa mandar um robô “encontrar o telefone a cinco metros a sudoeste e trazer até aqui”, não há muito o que um assistente possa fazer sem instruções exatas.

Para resolver isso, os pesquisadores do Facebook construíram uma nova ferramenta de código aberto chamada SoundSpaces, projetada para a chamada “IA incorporada” – um campo da inteligência artificial que prefere preencher corpos físicos (como robôs) com software antes de treiná-los no mundo real.

IA incorporada é treinada em ambiente virtual antes de chegar ao mundo real. Imagem: Reprodução

Em vez de usar conjuntos de dados estáticos, como a maioria dos métodos tradicionais, a IA incorporada favorece uma abordagem que aproveita a aprendizagem por reforço, na qual os robôs aprendem a partir de suas interações com o mundo real.

Nesse caso, o SoundSpaces permite aos desenvolvedores treinar sistemas de IA incorporados em ambientes 3D que representam espaços internos, com acústica altamente realista, capaz de simular qualquer fonte de som – em um andar de escritório ou em uma casa de dois andares, por exemplo.

Incorporar a captação de áudio no treinamento não apenas permite que a IA identifique diferentes sons corretamente, como também faz com que o sistema adivinhe de onde o ruído está vindo e possa se mover até ele. Ao ouvir um som, o sistema pode descobrir se o objeto emissor está perto ou longe, à direita ou à esquerda, e então se mover em direção a ele. De certa forma, o algoritmo é capaz de “ver” e “ouvir”, além de fazer a ponte entre diferentes dados sensoriais para atingir um certo objetivo.

Mapeamento de espaços

Paralelamente, os pesquisadores também lançaram uma ferramenta chamada SemanticMapNet, para ensinar assistentes virtuais a observar, explorar e lembrar de um espaço desconhecido, criando um mapa em 3D do ambiente para orientar os sistemas em tarefas futuras.

Portanto, essa ferramenta permitirá que os robôs informem se trancaram a porta da frente ou quantas cadeiras foram colocadas na sala de reuniões. Com essa tecnologia, eles são capazes de reconhecer objetos específicos, como uma mesa ou um sofá, em uma visão em primeira pessoa, antes de mapear o ambiente em 3D. O mapa independe da localização do robô no local.

Por outro lado, os métodos tradicionais de mapeamento contam apenas com a percepção em primeira pessoa ao longo do processo, sem uma visão em 3D, resultando em falhas e ineficiência. Objetos pequenos passam despercebidos, enquanto objetos grandes parecem ainda maiores.

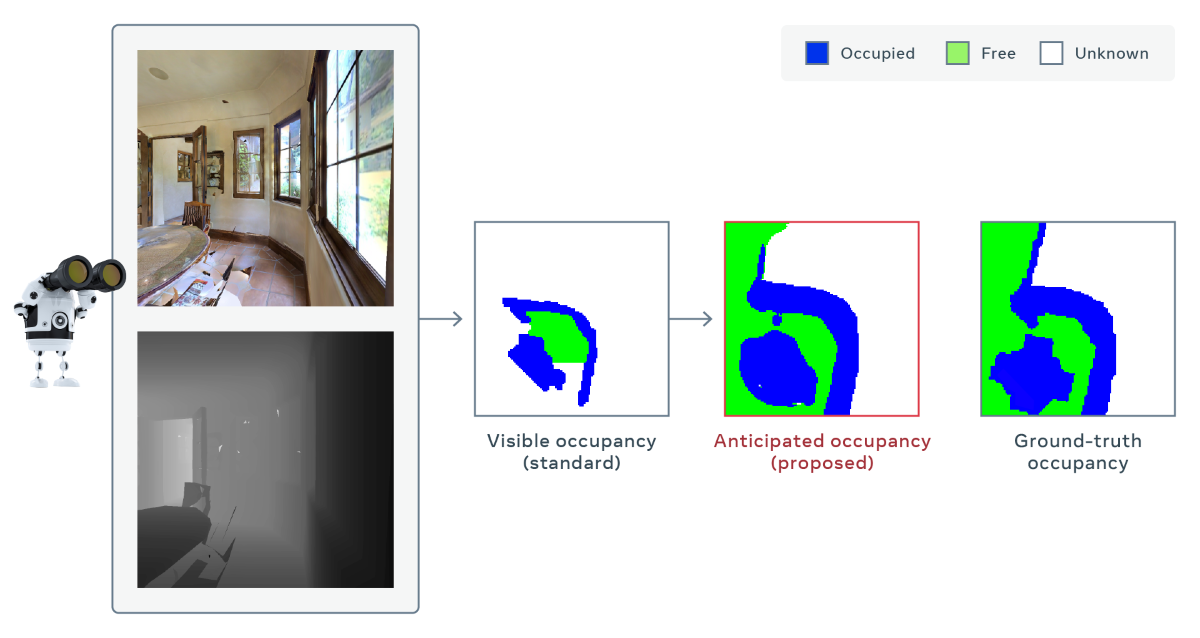

Além disso, a equipe equipou seu sistema com a capacidade de antecipar o layout de partes da sala que ele não consegue ver. Graças a um protocolo chamado “abordagem de antecipação de ocupação”, a IA pode prever efetivamente as partes do mapa que não está vendo diretamente. Em uma sala de jantar, por exemplo, o robô pode antecipar que há espaço livre atrás da mesa ou que uma parede parcialmente visível se estende até um corredor fora de vista.

Segundo os cientistas, os robôs superaram “o melhor método concorrente” com um mapa 30% mais preciso para a mesma quantidade de movimentos realizados.

O sistema é capaz de prever partes do mapa sem observá-las diretamente. Imagem: Facebook

Disponibilidade

As novas ferramentas estão disponíveis no Habitat, a plataforma de simulação da empresa projetada para treinar sistemas de IA incorporados em ambientes 3D realistas. O Habitat foi lançado no ano passado como um projeto de código aberto, como parte de um esforço para fornecer uma plataforma padrão para fazer experimentos com esse tipo de IA e comparar resultados.

Para familiarizar os assistentes virtuais com o mundo real, o Habitat inclui o conjunto de dados do Facebook Reality Labs, que contém réplicas detalhadas de vários espaços em 3D. O Habitat também é compatível com conjuntos de dados existentes, como Gibson e Matterport3D.

O próximo passo é transferir as habilidades desenvolvidas na plataforma virtual para robôs reais. Os pesquisadores descreveram os primeiros experimentos nesse sentido como “promissores”. No entanto, ainda não é algo que teremos em nossas casas em alguns dias.

Ainda assim, se aplicadas a tecnologias como carros autônomos, a IA incorporada pode ter vários benefícios. Os sistemas de bordo podem aprender sobre o trajeto enquanto dirigem e antecipar obstáculos. A tecnologia também pode ajudar robôs de busca e resgate, que podem ouvir e encontrar pessoas em situações de risco.

Via: ZDNet