Com a evolução da tecnologia, a inteligência artificial (IA) se tornou parte integrada à vida das pessoas, facilitando muitas atividades. No entanto, mesmo ajudando no dia a dia, as armas começaram a se beneficiar de seu uso em situações de combate.

Atualmente, armas baseadas em IA formam algumas das estratégias de segurança mais importantes dos Estados Unidos, China e Rússia. Em alguns casos, inclusive, as armas possuem poderes autônomos de funcionamento baseados em inteligência artificial. Isso faz com que, em teoria, essas máquinas possam tomar decisões próprias para ferir e matar pessoas com base em sua programação, sem qualquer intervenção humana.

Como justificativa para essa utilização, os países que as possuem apontam que essas armas com IA são uma forma de responder a ameaças emergentes em velocidade superior à humana. Eles também afirmam que elas reduzem o risco para os militares e aumentam a capacidade de acertar alvos com maior precisão.

No entanto, terceirizar as decisões que envolvem o uso de força viola a dignidade humana – além de ser incompatível com o direito internacional, que exige julgamento humano considerando o contexto das situações.

Na verdade, o papel desempenhado por pessoas nas decisões sobre o uso da força tem sido alvo de discussões constantes em reuniões das Nações Unidas. Em muitas das ocasiões, foi defendida a ideia de que é inaceitável por motivos éticos e legais delegar decisões sobre o uso da força a máquinas “sem qualquer controle humano”.

Discussão de ações

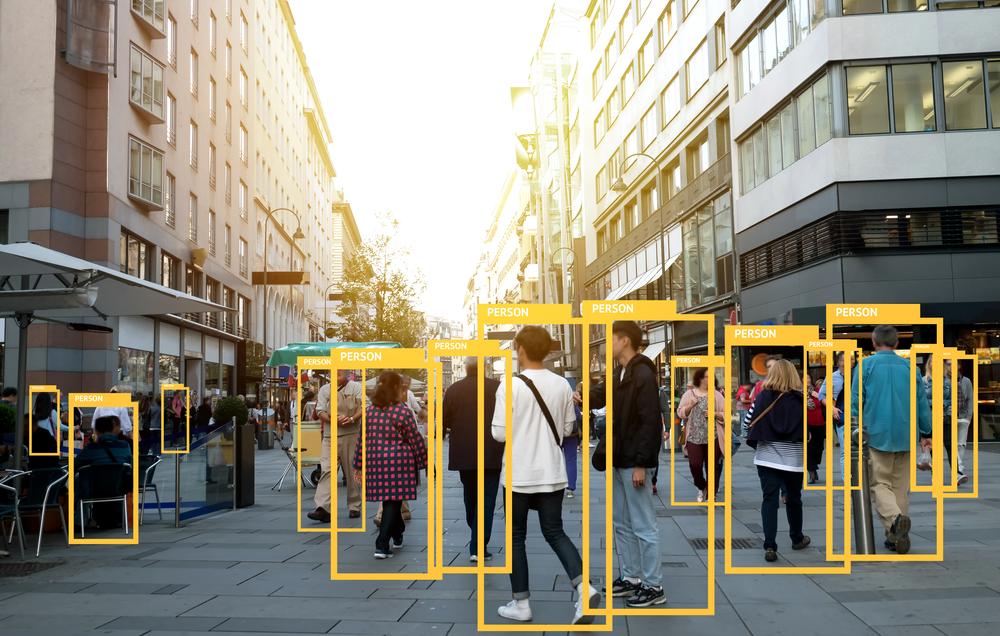

Armas controladas por inteligência artificial são alvo de discussões constantes. Foto: Laurent T/ Shutterstock

Muitos locais, como os Estados Unidos e o Reino Unido, possuem uma perspectiva um pouco diferente sobre controle humano. Por conta disso, eles defendem um modelo de perspectiva distribuída em relação à operação desses equipamentos.

De acordo com eles, o controle humano acontece em todo o ciclo de vida das armas – do desenvolvimento ao uso em algumas situações. Por isso, segundo os defensores, os equipamentos são projetados para agir como se fossem pessoas tomando essas decisões. No entanto, ao contrário das máquinas, as ações humanas de usar a força não são programadas.

De fato, o peso das obrigações do direito internacional humanitário se aplica às decisões de usar ou não uma tática ofensiva. Por isso, a mente humana pode considerar alguns fatores que talvez as armas controladas por IA não podem.

Isso porque algumas decisões rápidas requerem avaliação humana constante – que não podem ser obtidas com um algoritmo. Esse é especialmente o caso da guerra urbana, em que civis e combatentes estão no mesmo espaço.

Ter máquinas capazes de tomar a decisão de acabar com vidas humanas viola a dignidade das pessoas ao reduzi-las a objetos. Como apontado por Peter Asaro, filósofo da ciência e tecnologia, “uma máquina não pode ser programada para apreciar o valor da vida humana”.

Por conta dessas questões, muitos governos defendem novas regras gerais para garantir o controle humano sobre os sistemas de armas autônomos. Mas, alguns outros, incluindo os Estados Unidos, afirmam que a legislação internacional existente é suficiente.

Via: TechXplore