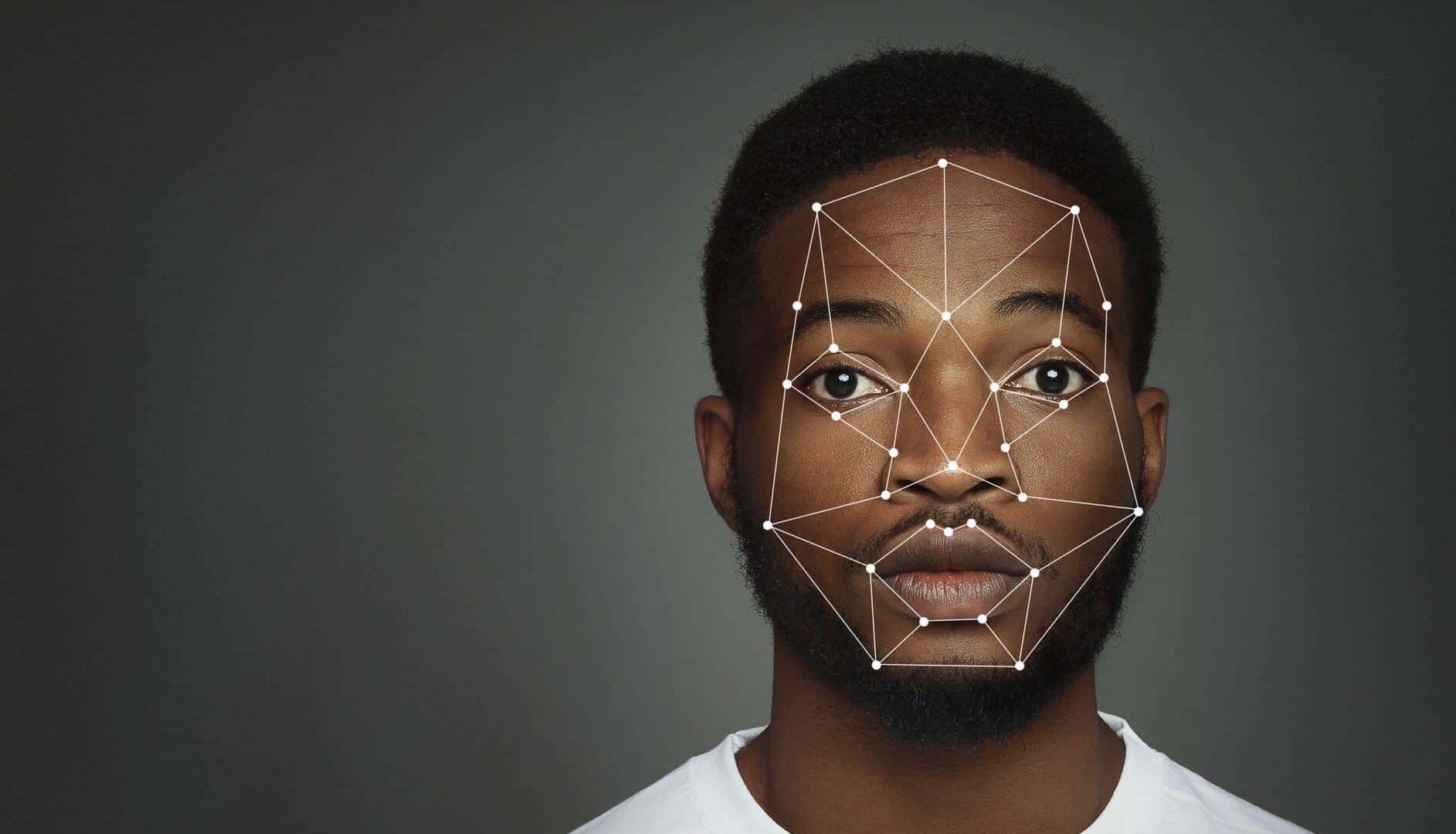

Há inúmeros debates sobre o uso de tecnologias de reconhecimento facial como prova condenatória de crimes. Por utilizarem testes em pessoas brancas, os algoritmos possuem uma probabilidade entre cinco e dez vezes de errar na identificação de pessoas negras.

Primeiro, é preciso compreender como funciona um algoritmo de reconhecimento facial. Para que eles funcionem, utiliza-se um modelo para treinar a inteligência artificial. A maioria desses modelos são baseados em imagens de pessoas brancas ou asiáticas.

Isso significa que um algoritmo de reconhecimento facial consegue identificar mais facilmente asiáticos e brancos às pessoas negras, em especial, mulheres.

Carros autônomos fazem uso da tecnologia para diferenciarem pessoas, animais, outros veículos e objetos. Fonte: Shutterstock

Carros autônomos fazem uso da tecnologia para diferenciarem pessoas, animais, outros veículos e objetos. Fonte: Shutterstock

Resultados de uma análise em julho de 2019 mostraram que o software de uma das maiores empresas de reconhecimento facial, a francesa Idemia, possuía maior probabilidade de identificar de forma incorreta mulheres negras em relação às mulheres brancas ou homens brancos e negros.

Em configurações de sensibilidade, o algoritmo identificou, de forma errada, mulheres brancas em uma taxa de uma para cada 10 mil. No caso de mulheres negras, a taxa foi de uma para 1 mil. Esse resultado mostra que há dez vezes mais chances de errar o reconhecimento facial em mulheres negras.

Segundo um estudo da NIST (National Institute of Standards and Technology), de 2018, os algoritmos de inteligência artificial se tornaram 25 vezes mais eficazes, com taxa de erro em cerca de 0,2%. Esse número, no entanto, não é o mesmo para pessoas negras.

Em 2019, em um caso de furto a uma joalheria de um shopping americano, Robert William foi preso pela identificação equivocada da tecnologia de reconhecimento facial. Segundo ela, William e o real autor do roubo eram a mesma pessoa: ambos estavam acima do peso e eram negros.

IBM desistiu temporariamente de comercializar o sistema de reconhecimento facial para departamentos de polícia norte-americanos. Fonte: Shutterstock/Reprodução

IBM desistiu temporariamente de comercializar o sistema de reconhecimento facial para departamentos de polícia norte-americanos. Fonte: Shutterstock/Reprodução

No fim maio, após uma onda de protestos tomarem as ruas Minneapolis, estado de Minnesota, pela morte de George Floyd, homem negro vítima da violência policial, gigantes da tecnologia como IBM, Microsoft e Amazon anunciaram que não mais iriam oferecer tecnologias de reconhecimento facial para órgãos policiais. As empresas também solicitaram ao congresso americano a regulamentação da tecnologia.

Apesar de pesquisas demonstrarem a ineficácia da tecnolgia para pessoas negras, o argumento parece não ter sido suficiente para que outro inocente negro fosse acusado equivocadamente por um crime que não cometeu. E na mesma cidade em que William foi preso.

O caso ocorreu em julho, Michael Oliver foi acusado de ter jogado o telefone de um professor no chão, quebrando sua tela. Ele foi condenado injustamente pelo crime de furto que ocorreu em maio de 2019.

À direita da imagem, o real suspeito de pegar o celular do professor. À esquerda, Michael Oliver, acusado injustamente pelo crime. Fonte: Detroit Free Press/Reprodução

À direita da imagem, o real suspeito de pegar o celular do professor. À esquerda, Michael Oliver, acusado injustamente pelo crime. Fonte: Detroit Free Press/Reprodução

O uso de tecnologia de reconhecimento facial preocupa, já que a tecnologia erra em 96% dos casos na identificação de suspeitos, segundo a própria polícia de Detroit, o que demonstra a ineficácia da tecnologia no combate ao crime.

Fonte: Detroit Free Press