A Microsoft criou um sistema de inteligência artificial que faz o mapeamento dos olhos de um usuário a fim de rastrear seus movimentos oculares. A proposta é usar a tecnologia para criar um método de navegação mais preciso e que simule, com o olhar, os movimentos de um mouse comum. A ideia é ajudar pessoas com dificuldades motoras, que, hoje, precisam gastar milhares de dólares em equipamentos mecânicos ou, no caso de soluções baseadas em software, lidar com a alta probabilidade de falhas de leitura.

A documentação primária publicada pela Microsoft não estabelece um nome para o recurso, mas detalha como ele encontra a sua origem em outra pesquisa similar: o EyeGazer, desenvolvido pelo MIT (Instituto de Tecnologia de Massachusetts), serve de inspiração para a empresa liderada por Satya Nadella. Vale citar, o Windows 10 foi o primeiro sistema operacional da Microsoft a contar com os recursos EyeControl, que permitem o controle do mouse pelo olhar; e o Eye Drive Library, que dá o mesmo controle a um joystick plugado no computador.

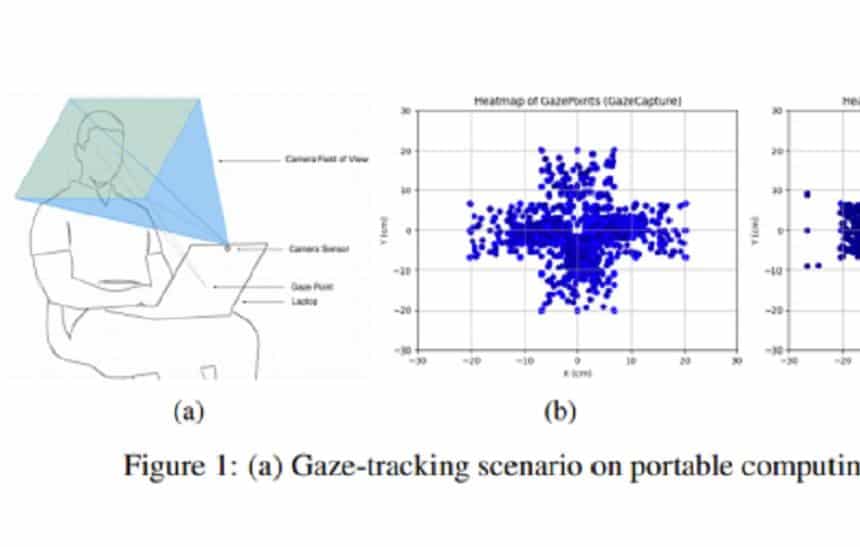

Gráfico que ilustra o mapeamento do rosto e olhos na tecnologia da Microsoft. Imagem: Microsoft/Divulgação

No modelo mais recente, a Microsoft mapeou a região frontal da face, o olho esquerdo e olho direito, separando-os em grades. Tais imagens são comparadas a modelos implementados em uma biblioteca (esta, baseada no algoritmo ResNet18). O resultado disso é o processamento de pontos de direção do olhar, separados em coordenadas. E o mais interessante: funciona em qualquer webcam.

O modelo criado pela Microsoft então pega tudo isso e “treina” suas capacidades preditivas na biblioteca de dados do EyeGazer, ao mesmo tempo em que conduz aprimoramentos de dados para conseguir antecipar eventuais alterações de ângulo e movimentos do rosto, imitando possibilidades no mundo real. De forma aleatória, o modelo altera volumes de brilho, contraste, saturação e cor a fim de aprender a lidar com mudanças que softwares de rastreamento ocular atuais não conseguem processar.

Finalmente, o modelo completo ainda usa uma biblioteca de sistemas de detecção facial chamada “Dlib”, que considera movimentos como rotação da cabeça e tronco, exibindo imagens mais vívidas, em melhor definição e de melhor qualidade. Isso é importante, já que o EyeGazer do MIT, por exemplo, não considera capturas acima das sobrancelhas ou abaixo dos lábios. Depois de um processo que envolve remapear as imagens da Dlib ao modelo pré-existente da Microsoft, a tecnologia resultante insere movimentos completos da cabeça, olhos e expressões faciais no quadro original de 25 x 25 linhas.

Ilustração que mostra a captura do sistema desenvolvido pelos pesquisadores. Imagem: Microsoft/Divulgação

Os autores do projeto determinaram que os modelos tendem a se concentrar mais no monitoramento dos olhos, mas também prestam atenção na sobrancelha e na borda inferior da pálpebra. Em outras palavras, não enxergam apenas o movimento do olhar, mas também identificam os músculos faciais ativados quando uma pessoa, por exemplo, move o olho junto do rosto em uma direção qualquer.

“Modelos trigonométricos que se concentram apenas na pupila e na íris não necessariamente captam esses detalhes e, por isso, esse é o ponto que o aprendizado aprofundado [da IA] pode explorar a fim de aprimorar a sua precisão”, disseram os pesquisadores.

Como o estudo publicado ainda é uma premissa, ou seja, ainda não tem uma aplicação em ambiente real, o objetivo dos autores agora é o de estabelecer arquiteturas de redes neurais customizadas para melhorar ainda mais a performance: “O rastreamento do olhar, enquanto tecnologia de acessibilidade, tem muitos obstáculos, incluindo a falta de interoperabilidade e a inexistência de um conjunto de dados diversificado e grande, que cubra problemas de ocultação da face, movimentos e poses da cabeça e diversas condições dos olhos”, os estudiosos afirmaram. “Essa pesquisa traz a promessa de que, um dia, qualquer computador, tablet ou smartphone seja controlável pelo dos seus olhos graças à capacidade preditiva de redes neurais”.

Fonte: Venture Beat