A DeepMind, empresa que pertence ao Google (na verdade, à Alphabet) venceu o coreano Lee Se-dol, campeão mundial do jogo de tabuleiro oriental Go. Foi só uma partida de uma melhor de cinco, mas não deixa de ser significativo: uma inteligência artificial foi capaz de vencer um jogador lendário de Go, e isso é uma marca histórica, que remete à clássica disputa entre o DeepBlue, da IBM, contra Garry Kasparov, lenda do xadrez, em 1996.

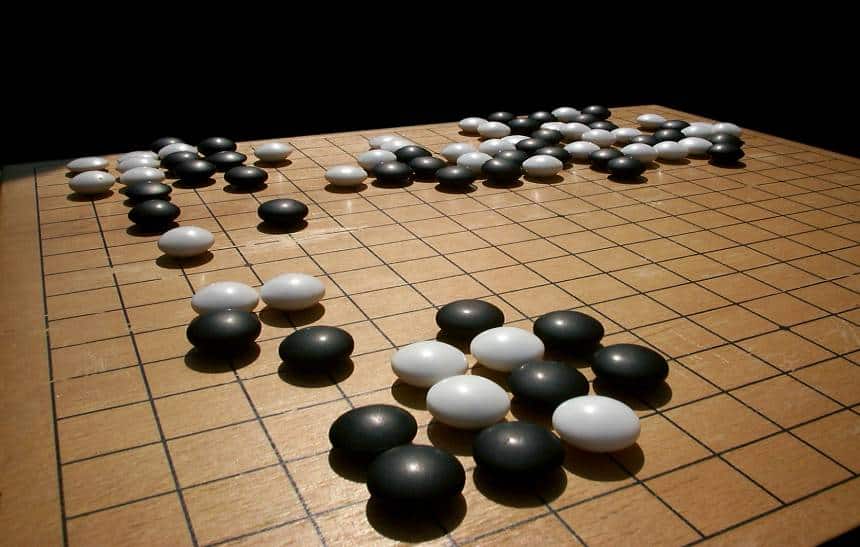

A questão é que o jogo de Go é muito mais complexo do que o xadrez, apesar de ter regras muito simples. A partida se dá em um tabuleiro de 19×19, com jogadores se alternando na colocação de peças pretas e brancas com intuito de cercar pontos no tabuleiro para conquistar o território oponente.

O problema é que uma única partida de Go tem um número enorme de possibilidades, o que faz com que ele tenha muito mais variedade de movimentos do que o xadrez. Uma única partida permite cerca 10171 de posições no tabuleiro. Sim, é um número 1 seguido de 171 zeros, valor que é maior do que a quantidade estimada de átomos no universo inteiro.

Isso explica o atraso da inteligência artificial jogadora de Go em comparação com a do xadrez, que já supera os humanos há quase 20 anos. Os jogadores humanos afiam sua intuição e capacidade de reconhecer padrões de jogo ao longo de muitos anos. A palavra-chave é “intuição”, porque se trata de um jogo muito profundo, embora simples, o que significa que há muito pouco que pode ser deduzido ao olhar para o tabuleiro; é necessário extrapolar a informação para poder criar uma estratégia de jogo.

O computador do Google, usando o algoritmo AlphaGo, conseguiu a vitória graças a redes neurais e aprendizado profundo para aprender a jogar. O conceito é similar, por exemplo, ao Google Fotos. O serviço da empresa reconhece a foto de um cachorro ou de um gato por ter em seu banco de dados um número enorme de fotos de cachorros e gatos, permitindo que o algoritmo seja capaz de fazer a comparação com seu banco de dados. No caso de Go, isso é feito acompanhando milhões de posições de Go de jogos com participantes humanos.

O computador também é capaz de melhorar graças à capacidade do sistema em jogar contra si mesmo. Ele joga milhões de vezes contra versões melhoradas de si mesmo, o que faz com que a máquina progressivamente fique melhor no jogo. Assim, o AlphaGo consegue criar um tipo de “política” que ajuda a determinar o próximo movimento, o que acaba atribuindo um valor para verificar e avaliar as posições. Esta prática ajuda a reduzir a quantidade de trabalho necessária para um único movimento, reduzindo a amplitude das buscas a cada movimento e evita que seja necessário calcular todo o jogo antes que ele seja completado.

O processo é muito diferente, por exemplo, do que o usado na já citada partida entre o DeepBlue da IBM e o enxadrista Garry Kasparov. Na ocasião, foi usada pura força bruta computacional para encontrar o melhor movimento para vencer a partida. Isso simplesmente não é prático com o Go, porque, como dito acima, são muito mais movimentos por jogo, o que exigiria um poder computacional muito maior do que temos hoje. Em vez de força bruta, é necessário criar, de fato, estratégias inteligentes

Alguns podem se perguntar: “qual a necessidade e vantagem de criar um computador tão bom em Go?”. O fato é que o desenvolvimento da inteligência artificial pode trazer vantagens práticas, com aplicações mais amplas do que simplesmente um jogo de tabuleiro. O Google pensa que suas técnicas de aprendizado de máquina podem ser úteis em um contexto mais geral, como robótica, em sistemas de assistentes para smartphones (como o Google Now), e até mesmo na medicina. Na verdade, a DeepMind já anunciou um acordo com o Serviço Nacional de Saúde do Reino Unido, para usar suas técnicas para criar aplicativos para ajudar profissionais da medicina a identificar pacientes em riscos de complicações. O foco inicial é a insuficiência renal aguda.