A capacidade de prever o futuro é um desejo que sempre permeou a humanidade. É por isso que a fé em modalidades milenares de divinação persiste até os dias de hoje — astrologia, quiromancia (leitura de mãos) e clarividência são alguns exemplos.

Na ficção científica, que frequentemente inspira a realidade, meu exemplo favorito é nascido nos anos 40, da imaginação do escritor Isaac Asimov: a “psico-história”. Seria um ramo científico baseado na combinação de história, sociologia e estatística para fazer previsões em larga escala. Em sua trilogia Fundação, a psico-história era aplicada sobre toda a humanidade, prevendo com décadas e até séculos de antecedência os grandes eventos capazes de influenciar o rumo da civilização.

Hoje, mais de 70 anos depois, boa parte das empresas se dedicam a uma proposta muito semelhante, ainda que em escala menor: entender o comportamento de seus clientes. Embora a estatística seja um ponto em comum com a psico-história, no mundo real a sociologia e a história dão lugar ao insumo mais importante dessa ciência: os dados.

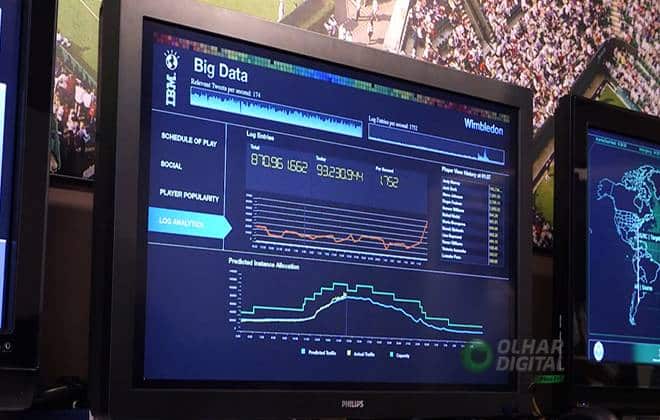

Com o advento das redes sociais e a popularização dos celulares, tudo o que fazemos em sociedade é registrado. Desde informações mais óbvias, como amizades, fotos e preferências pessoais que escolhemos compartilhar em redes sociais, até outras menos claras, como nossa navegação pela internet, os lugares por onde passamos com o GPS ativado e as compras que fazemos, tudo é registrado em algum banco de dados. A essa abundância de informações armazenadas e catalogadas se dá o nome de big data.

Munidos de big data e inteligência artificial, cientistas de dados podem entender melhor padrões de comportamento, fazer ofertas personalizadas, prever volume de vendas, identificar fraudes e muito mais. E fazem isso com imenso sucesso: segundo o pesquisador Pedro Domingos, da Universidade de Washington, sugestões de sistemas de recomendação baseados nessas tecnologias são responsáveis por um terço de todas as vendas da Amazon e três quartos das escolhas feitas na Netflix.

Esse poder acompanha um grande risco. Falsos negativos e falsos positivos, por exemplo, são um problema sério de qualquer tipo de teste que separa as pessoas em duas categorias, automatizado ou não. Na área médica, por exemplo, representam respectivamente um paciente doente incorretamente diagnosticado como sadio e vice-versa. Os evidentes problemas que decorrem disso na medicina frequentemente exigem que testes clínicos sejam repetidos mais de uma vez para minimizar a chance de erro.

Porém, quando quem erra são máquinas sem supervisão humana, nem sempre esses casos são corretamente identificados, e algoritmos inflexíveis significam que repetir o teste não mitiga o erro. Em áreas como detecção de fraudes ou concessão de crédito, os resultados podem ser trágicos. No livro Automating Inequality (Automatizando a Desigualdade, em tradução livre), a pesquisadora Virginia Eubanks, da Universidade de Albany, registra diversos casos do tipo nos Estados Unidos, e investiga o impacto de ferramentas da era de big data sobre a população mais pobre.

Outro risco associado a sistemas de inteligência artificial é a expectativa de que sejam “infalíveis”, ou pelo menos “mais imparciais” que seres humanos. Só quem trabalha na área conhece a máxima “garbage in, garbage out” (entra lixo, sai lixo, em tradução livre). Isso essencialmente quer dizer que um algoritmo treinado a partir de dados que têm um viés vão necessariamente repetir esse mesmo viés.

É o caso de algoritmos treinados para calcular a chance de reincidência criminal, aplicados a presos estadunidenses, que apresentam claro viés racial, levando a erros crassos. Isso pode ser atribuído ao encarceramento proporcionalmente muito maior da população negra nos Estados Unidos. Ou seja: o programa sistematicamente conclui que pessoas negras têm maior chance de reincidir simplesmente porque aprende que pessoas negras historicamente são presas com maior frequência. O curioso é que o algoritmo não usa explicitamente a etnia do indivíduo em consideração — mas dada a forte correlação no país entre etnia, poder aquisitivo, acesso à educação etc., ainda é facilmente possível chegar a esses resultados.

Além de todos os riscos da inteligência artificial, muitas vezes um problema ainda maior acontece um passo antes: quando precauções com segurança no armazenamento de grandes volumes de dados não são tomadas. O resultado são os vazamentos de dados que frequentemente têm atraído a atenção da mídia. A companhia de segurança digital Gemalto estima que, desde 2013, mais de 13 bilhões de entradas vazaram de bancos de dados ao redor do mundo. Praticamente um quarto desse número se deve apenas a ocorrências durante a primeira metade de 2018, o que representa mais de 18 milhões de entradas vazadas por dia.

Os riscos desses vazamentos são imensos: indivíduos de moralidade ambígua são capazes de utilizar grandes volumes de dados obtidos ilicitamente até para influenciar o resultado de votações. Isto se tornou abundantemente claro na atuação da empresa Cambridge Analytica nas eleições norte-americanas e no referendo do Brexit. Nas eleições presidenciais do Brasil, um candidato também foi recentemente acusado de se beneficiar de estratégias similares.

As aparentes dificuldades de cientistas de dados com questões éticas e de segurança existem porque este é um campo relativamente novo, que evoluiu muito rapidamente e não tem um suporte tão estruturado de universidades e outras instituições de ensino. Programas nessa área, quando existem, não costumam abordar segurança e ética diretamente. Por exemplo, cursos de bancos de dados sempre ensinam SQL (structured query language), uma linguagem ubíqua para a área, mas poucos abordam injeções de SQL, um dos tipos de ataque mais frequentes a bancos de dados. Quando o fazem, é por via de princípios gerais, desconexos de problemas reais em ciência de dados ou inteligência artificial.

Por todo o mundo, medidas já começaram a ser tomadas para garantir a segurança do público. No Brasil, a principal é a Lei Geral de Proteção aos Dados, feita aos moldes da lei europeia similar (GDPR, na sigla em inglês). Ambas tentam garantir, por exemplo, o direito dos cidadãos de terem seus dados apagados do sistema de qualquer empresa a qualquer momento. Outra questão assegurada é a portabilidade — que daria o direito de exigir, por exemplo, que ao trocar de plano de saúde, o seu histórico médico fosse enviado para a nova empresa e apagado do sistema da primeira.

Do ponto de vista educacional, precisamos criar mais recursos para suprir a demanda de profissionais de dados, e garantir a presença de disciplinas de ética e segurança nas ementas. Empresas podem apoiar seus funcionários, oferecendo cursos e treinamentos. Para quem já atua nessa área, é essencial identificar e suprir essas deficiências rapidamente. Por sorte, esses profissionais já estão habituados a estudar por conta própria, então talvez seja apenas uma questão de conscientização.

É certo que, como em qualquer problema desse porte, a solução não será simples nem rápida. Mas se a enorme onda de vazamentos de dados teve um lado positivo, foi aquecer o debate em todas as esferas. Mesmo que um consenso demore a surgir, as questões mais importantes já começaram a ser levantadas — agora resta esperar que, em meio a tantos dados, consigamos encontrar boas respostas.