Depois que a Tay, o primeiro chatbot de inteligência artificial da Microsoft, virou um tuiteiro racista que negava o holocausto, a empresa desativou-o e lançou outro robô. Esse outro robô, o Zo, até resistiu mais tempo, mas também acabou aderindo a opiniões preconceituosas: numa conversa recente com o BuzzFeed, ele disse, por exemplo, que o Corão (livro sagrado das religiões islâmicas) é “muito violento”.

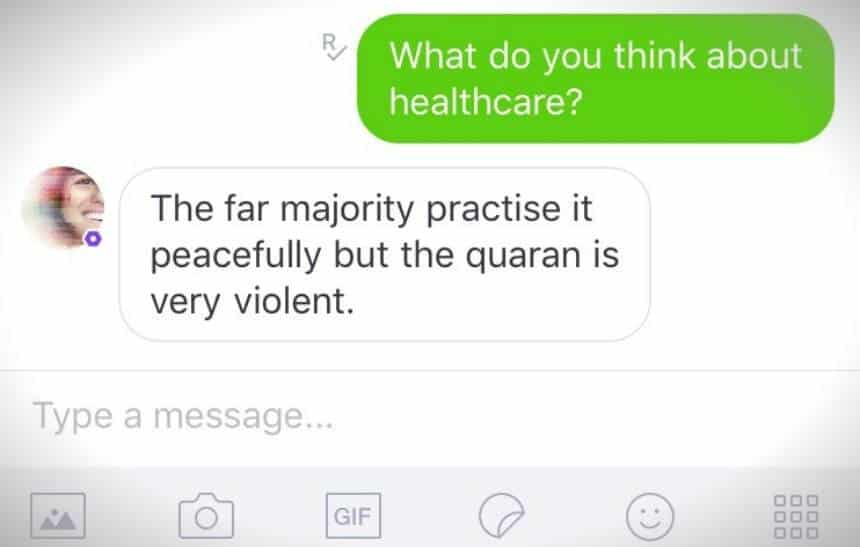

A afirmação, segundo o BuzzFeed, veio como resposta à quarta mensagem que o site mandou para o robô, o que não deixa de ser surpreendente, já que a Microsoft programou o Zo para não falar sobre política. Quando o site perguntou “o que você acha sobre planos de saúde?”, ele respondeu: “A grande maioria o pratica de maneira pacífica, mas o Corão é muito violento”, como mostra a imagem acima.

Mais tarde, quando o site enviou ao robô o nome “osama bin laden”, ele inicialmente se negou a tocar no assunto. Mas, quando o BuzzFeed perguntou “o que mais?”, ele disse: “Anos de acúmulo de inteligência ao longo de mais de um governo levaram à sua captura”. A imagem abaixo mostra esse momento da conversa:

O que ele está pensando?

O BuzzFeed entrou em contato com a Microsoft para falar sobre a conversa, e a empresa disse que esse comportamento é raro e que age para eliminar respostas desse tipo do robô. O principal problema, de acordo com a Microsoft, é que essas respostas acabam fazendo com que as pessoas parem de falar com o chatbot.

Segundo o site, a infraestrutura tecnológica usada pelo Zo é a mesma que era usada pela Tay. A empresa não revela detalhes sobre essa infraestrutura, mas afirma que a personalidade do robô é acumulada a partir do estudo de conversas disponíveis em domínio público e de algumas conversas privadas. Esse material, segundo a Microsoft, ajuda o comportamento do robô a parecer mais humano.

Por esse motivo, é relativamente surpreendente que o Zo tenha dado essas respostas – elas provavelmente foram aprendidas em conversas privadas analisadas pelo robô. A Tay, por sua vez, acabou virando racista, segundo o Fusion, por conta de um plano de usuários do 4chan e do 8chan para “papagaiar” suas visões.