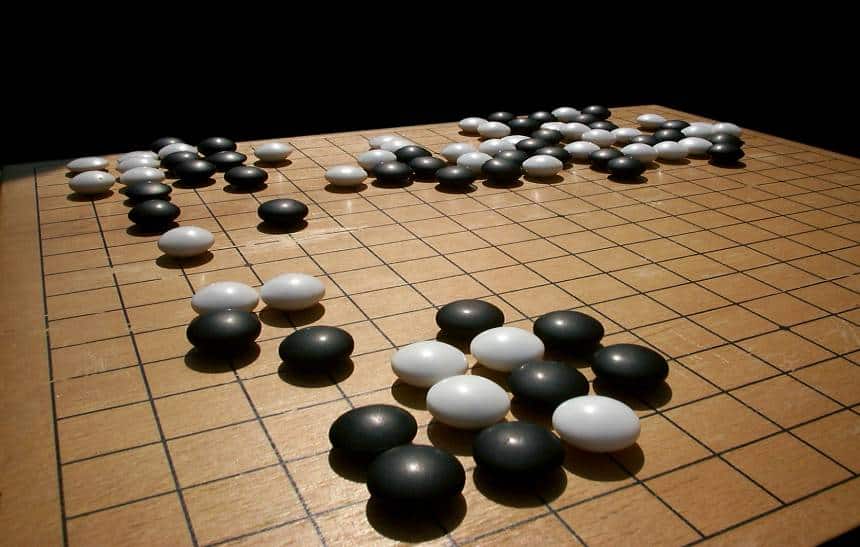

Você talvez se lembre do grande feito da DeepMind, uma empresa subsidiária do Google, que criou a inteligência artificial AlphaGo capaz de dominar o jogo de tabuleiro Go, vencendo até mesmo o campeão mundial na modalidade. Agora a empresa foi além: criou a AlphaGo Zero, uma nova versão de seu algoritmo que foi capaz de fazer o mesmo em menos tempo e sem intervenção humana.

O software original impressionou até os mestres jogadores de Go pela sua capacidade e refinamento, mas o fato é que para chegar até esse ponto, o sistema dependeu de jogadores humanos e seus talentos para aprender a melhor forma de mover suas peças. Para começar, a empresa precisou injetar um conjunto de dados de 100 mil jogos de Go para dar à máquina o conhecimento básico.

Enquanto isso, a AlphaGo Zero, foi programada apenas com as informações que forneceram ao sistema as regras básicas do jogo, sem orientações de como transformar essas premissas básicas em técnicas de jogo eficientes. Bastaram apenas 40 dias para dominar um jogo de 3 mil anos e se tornar o novo campeão mundial.

Como o computador chegou a esse nível? Em vez de usar um banco de dados com base em jogos entre humanos, a máquina aprendeu jogando contra si mesmo inúmeras vezes. No começo, a IA apenas jogava peças de forma aleatória no tabuleiro. A cada vitória, o sistema era atualizado; ou seja: ele aprendia algo novo. Repetindo isso milhões de vezes, a máquina conseguiu começar a desenvolver suas próprias estratégias.

Depois de três dias aprendendo a jogar nesse esquema, a AlphaGo Zero foi colocada para jogar contra a versão de sua antecessora que havia vencido Lee Se-dol, o coreano 18 vezes campeão mundial na modalidade. Foram 100 partidas e 100 vitórias para versão Zero.

Mas o avanço não parou por aí. Na sequência, ela passou a treinar para enfrentar a versão mais avançada da AlphaGo, descrita como um ‘deus’ após derrotou chinês Ke Jie, número 1 de Go no planeta. Em 40 dias, a taxa de vitórias da Zero sobre a AlphaGo era de 90%.

Tudo isso feito sem a utilização de quaisquer dados de origens humanas. “Ao não usar dados humanos, sem usar a perícia humana em qualquer nível, nós removemos os limites do conhecimento humano”, diz David Silver, programador-chefe no projeto da AlphaGo Zero. “O sistema é capaz de criar conhecimento a partir dos princípios básicos, como uma folha em branco. Isso permite que ele seja muito mais poderoso que as versões anteriores”, concluiu.

Mais do que apenas formar um jogador melhor, a nova abordagem traz algumas vantagens. Uma delas é o fato de que o sistema depende de menos poder de processamento, usando apenas 4 TPUs (processadores especializados em inteligência artificial criados pelo Google) contra 48 usados pelas versões anteriores. Além disso, ele soluciona algumas das críticas mais contundentes contra a tecnologia da inteligência artificial, dependendo demais de intervenção humana, que alimentam sistemas com bancos de dados enormes, e avanços que podem ser atribuídos ao acesso a energia elétrica barata para alimentar data centers gigantescos dedicados a processar volumes cavalares de informação.

Agora a missão da DeepMind é ir além do Go. É razoavelmente fácil para um computador dominar um jogo de tabuleiro deste tipo, onde não há elemento de sorte, não há variáveis externas e é plenamente possível ter acesso a uma simulação digital perfeita do jogo do tabuleiro físico. A missão da empresa é criar algoritmos capazes de aprender qualquer coisa, e não apenas um jogo. Como essa tecnologia será usada no futuro, no entanto, ainda é um mistério, mas os objetivos são ambiciosos.

Como os métodos de aprendizado de máquina que a DeepMind utilizou no AlphaGo são de uso geral, a empresa pretende em breve começar a aplicá-los em outras áreas. Segundo o fundador Demis Hassabis, a empresa foi criada para permitir que a inteligência artificial seja “usada como uma ferramenta para ajudar a sociedade a resolver alguns de seus problemas