A DeepMind, empresa de inteligência artificial que pertence ao Google, conseguiu ensinar um sistema a ler os lábios de pessoas em imagens gravadas e fornecer legendas para o que elas estavam dizendo. No final do período de treinamento, o sistema conseguia realizar leitura labial de imagens gravadas com precisão superior à de profissionais treinados para isso.

Foram usadas cerca de 5 mil horas de programação da BBC, incluindo noticiários, para treinar a máquina. De acordo com a New Scientist, elas continham um total de aproximadamente 118 mil frases inteiras. Programas que foram ao ar entre janeiro de 2010 e dezembro de 2015 foram usados como conjunto de treinamento, e o sistema foi testado usando programas de entre março e setembro de 2016.

Dentre as frases que a máquina foi capaz de legendar estavam sentenças bastante complexas, como “We know there will be hundreds of journalists here as well” (sabemos que haverá centenas de jornalistas aqui também) e “According to the latest figures from the Office of National Statistics” (de acordo com os números mais recentes do escritório de estatísticas nacionais).

Organizando os estudos

Um dos desafios da máquina – além de aprender a ler lábios – foi preparar o seu próprio material de estudo. Isso porque os arquivos de programas de TV disponíveis estavam com áudio e vídeo dessincronizados; em alguns casos, havia mais de um segundo de defasagem entre as duas coisas. Isso fazia com que fosse impossível para o sistema criar associações entre os sons e a posição dos lábios das pessoas que apareciam na tela.

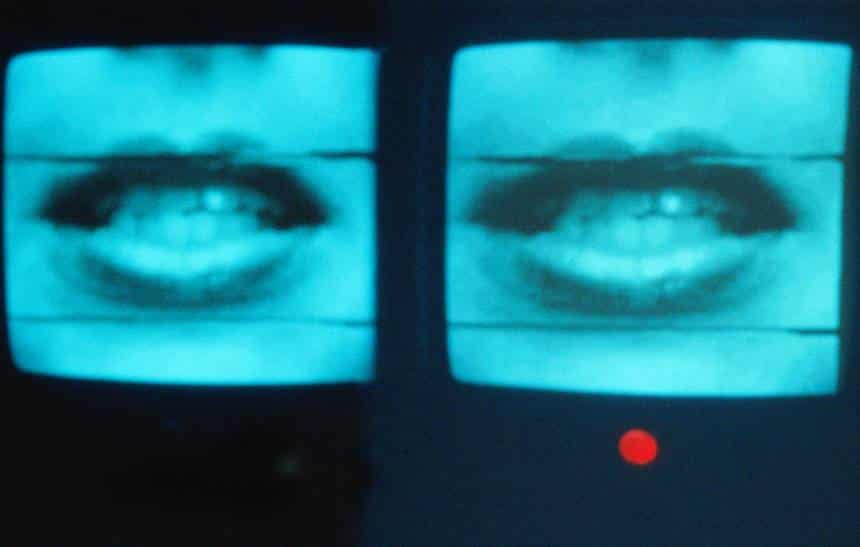

Para resolver esse problema, o sistema foi alimentado com algumas associações corretas entre sons e formatos de boca. Com essa informação, ele conseguiu sincronizar de novo o áudio e o vídeo das mais de 5 mil horas de material de treino. Em seguida, ele “assistiu” novamente a esse material para aprender novas relações entre sons e formatos de boca. Com o tempo, ele aprendeu a legendar frases da seguinte maneira:

Resultados

Com o fim de testar a eficiência do sistema, os pesquisadores da DeepMind e da Universidade de Oxford compararam o desempenho dele com o de um profissional em leitura labial. Os dois tiveram que decifrar 200 clipes selecionados aleatoriamente dos programas de teste. Enquanto o profissional conseguiu acertar 12,4% das palavras sem qualquer erro, a máquina acertou 46,8% delas.

Boa parte dos erros cometidos pela máquina, no entanto, eram pequenos (como não incluir um “s” no final de uma palavra que era plural) e de pouca relevância para o significado das frases. Com esse desempenho, a rede conseguiu superar até mesmo outros sistemas automatizados de leitura labial. Os pesquisadores disseram que pretendem liberar o material de treinamento da máquina para que ele possa ser usado para melhorar outros sistemas desse tipo.

Aplicações

Esse tipo de sistema pode ser usado para auxiliar pessoas com dificiências auditivas a entender o que está sendo falado em vídeos, filmes e programas de TV. A possibilidade de se gerar legendas automaticamente com base em imagens é bastate útil para serviços de streaming como o YouTube e o Vimeo, que recebem diariamente milhares de novas horas de conteúdo.

Também seria possível utilizar esse método para que assistentes virtuais de smartphone pudessem ser ativados pelos lábios, e não pela voz. Se a Siri fosse capaz de ler os seus lábios usando a sua câmera frontal, por exemplo, ela jamais precisaria ouvir a sua voz de novo. Isso seria bastante útil, pois permitiria que os assistentes virtuais fossem usados mesmo em espaços públicos, sem que a voz do usuário incomodasse ou causasse estranhamento às pessoas próximas.

No entanto, há também um risco associado ao uso malicioso dessa tecnologia. Isso porque basta que uma câmera ligada a esse sistema consiga ver o rosto de um usuário para que ela consiga entender o que ele está falando. Nesse caso, preocupações sobre sigilo de informações se tornariam ainda mais importantes.