A DeepMind, empresa de inteligência artificial do Google, divulgou ontem três estudos sobre o uso de sistemas de aprendizagem de máquina para ensinar robôs a andar. Os sistemas permitiam que máquinas aprendessem sozinhas a andar em um ambiente simulado.

Segundo a empresa, dominar o controle motor necessário para a realização de tarefas como navegar por obstáculos “é um marco da inteligência artificial, e é uma parte crucial da pesquisa nesse ramo”. Mesmo assim, ele traz uma série de dificuldades. Por exemplo: no caso de ensinar robôs a jogar jogos de Atari, o objetivo é simples de se definir (ganhar o jogo). Mas é mais difícil explicar a uma máquina o jeito certo de se andar, pular ou dar uma cambalhota, por exemplo.

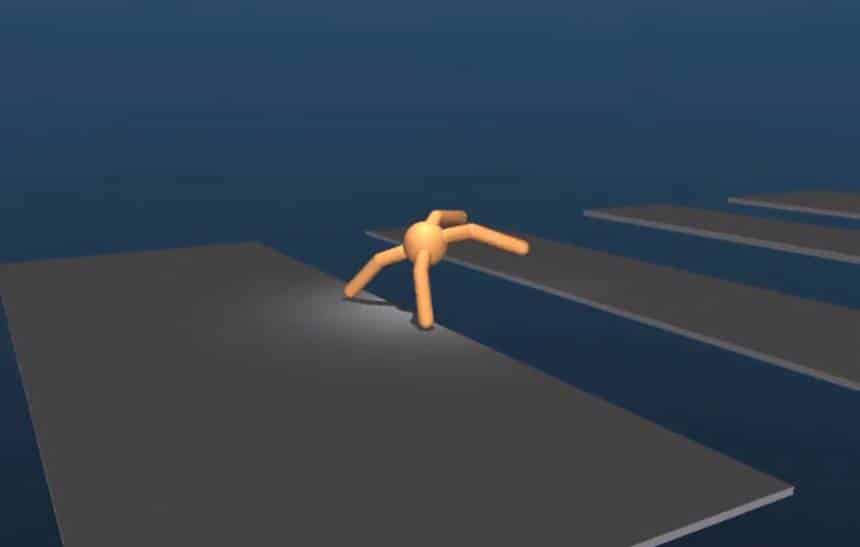

Um dos três estudos publicados pela empresa foca nesse problema: a definição do objetivo. Ele descreve uma rede neural capaz de ensinar máquinas a navegar por percursos complexos usando um objetivo muito simples: progresso horizontal. Tendo esse como seu único objetivo, os sistemas que usam essa rede conseguem aprender sozinhos a navegar percursos complexos, como o vídeo abaixo mostra:

Um passo por vez

Como os agentes recebiam apenas o objetivo de progredir à direita, e não instruções específicas sobre como se mover, o sistema de aprendizado pode ser usado para agentes de qualquer tipo. Desde agentes bípedes, que imitam comportamento humano, até outros tipos de robôs, como a aranha estranha que aparece no vídeo.

Mas como eles não recebem instruções detalhadas, eles podem acabar desenvolvendo métodos extremamente ineficientes de se mover. Uma maneira de garantir que eles aprendam a andar “como humanos” é mostrando a eles vídeos de humanos andando, e é nisso que o segundo estudo foca: o uso de dados de captura de movimentos de humanos andando para ensinar máquinas a andar.

Aprendendo com os amigos

No entanto, as maneiras estranhas de andar que os robôs desenvolvem podem ser úteis em algumas situações. A gente, por exemplo, precisa andar de maneiras diferentes para enfrentar obstáculos como buracos, pisos tortos ou barreiras. Esse é o objeto do terceiro estudo divulgado pela empresa: a transição entre comportamentos diferentes.

Para fazê-lo, a DeepMind criou um modelo que permite que os sistemas aprendam a imitar comportamentos observados em agentes diferentes. Assim, se um dos sistemas aprende, por exemplo, a navegar por planos inclinados, o outro consegue aprender a mesma coisa observado o primeiro. Não é só isso: ele também consegue entender quando precisa mudar para aquele novo comportamento.

Todos os estudos foram elaborados com base em simulações. Como é possível ver no vídeo, eles não mostram um robô de verdade andando, mas “agentes” virtuais em um ambiente virtual. Mesmo assim, a existência dos modelos de aprendizagem que permitem ensinar esse tipo de movimento é um avanço importante.