As três Leis da Robótica, idealizadas pelo escritor Isaac Asimov, funcionam muito bem na ficção, mas não na prática. Por exemplo, para uma Inteligência Artificial entender o comando “um robô não pode ferir um ser humano ou, por inação, permitir que um ser humano sofra algum mal”, ela precisaria compreender conceitos como “ser humano”, “ferir” e “sofrer algum mal”. A verdadeira inteligência está em entender os contextos.

Pesquisadores do Allen Institute for Artificial Intelligence (AI2) estão caminhando neste sentido. Eles desenvolveram um modelo de linguagem visual que pode gerar imagens com uma legenda. Por enquanto, as imagens são bem bizarras e o leque de possibilidades limitado, mas apontam na direção da criação de robôs cada vez mais inteligentes.

O estudo usou o mesmo método do GPT-3, o sistema desenvolvido pela OpenAI baseado em aprendizado de máquinas que possui a capacidade de escrever diversos tipos de gêneros textuais com grande verossimilhança a qualquer trabalho executado por um humano. Com poucos estímulos ele entrega poemas, contos e canções que enganam qualquer leitor desavisado.

“Uma grande torre do relógio pintada no meio da cidade”. Imagem: Allen Institute for Artificial Intelligence/Reprodução

Para chegar nesse ponto, o GPT-3 treinou com uma enorme quantidade de dados de texto. O que os cientistas do AI2 fizeram foi aplicar a mesma técnica, mas com textos e imagens. É semelhante ao que o BERT, do Google faz quando usa uma técnica chamada “mascaramento”, que envolve esconder palavras diferentes em uma frase e pedir ao modelo para preencher o espaço em branco.

Se o modelo for forçado a fazer esses exercícios por milhões de vezes, ele começará a descobrir padrões de como as palavras são reunidas em sentenças e as sentenças em parágrafos. O Google usa isso para fornecer resultados de pesquisa mais relevantes.

No caso do projeto da AI2, o sistema é alimentado com palavras e imagens, e analisa tanto o conteúdo do texto quanto os elementos da foto para preencher as lacunas. A ideia é que o modelo aprenda não apenas os padrões entre as palavras, mas também as relações entre as palavras e os elementos em cada imagem.

“Duas pessoas jogam videogame sentadas em um sofá”. Imagem: Allen Institute for Artificial Intelligence/Reprodução

O próximo passo foi reverter o processo. Para saber se o sistema realmente desenvolveu uma compreensão conceitual do mundo visual, os pesquisadores pediram para que o modelo começasse a gerassem imagens a partir das legendas – como uma criança que faz um desenho de um objeto quando lhe é pedido, sem que o objeto esteja lá.

Como resposta, o modelo entregou um padrão de pixels sem sentido. “Transformar texto em imagens é muito mais difícil do que o contrário. Uma legenda não especifica tudo o que está contido em uma foto”, explica a líder da equipe, Ani Kembhavi.

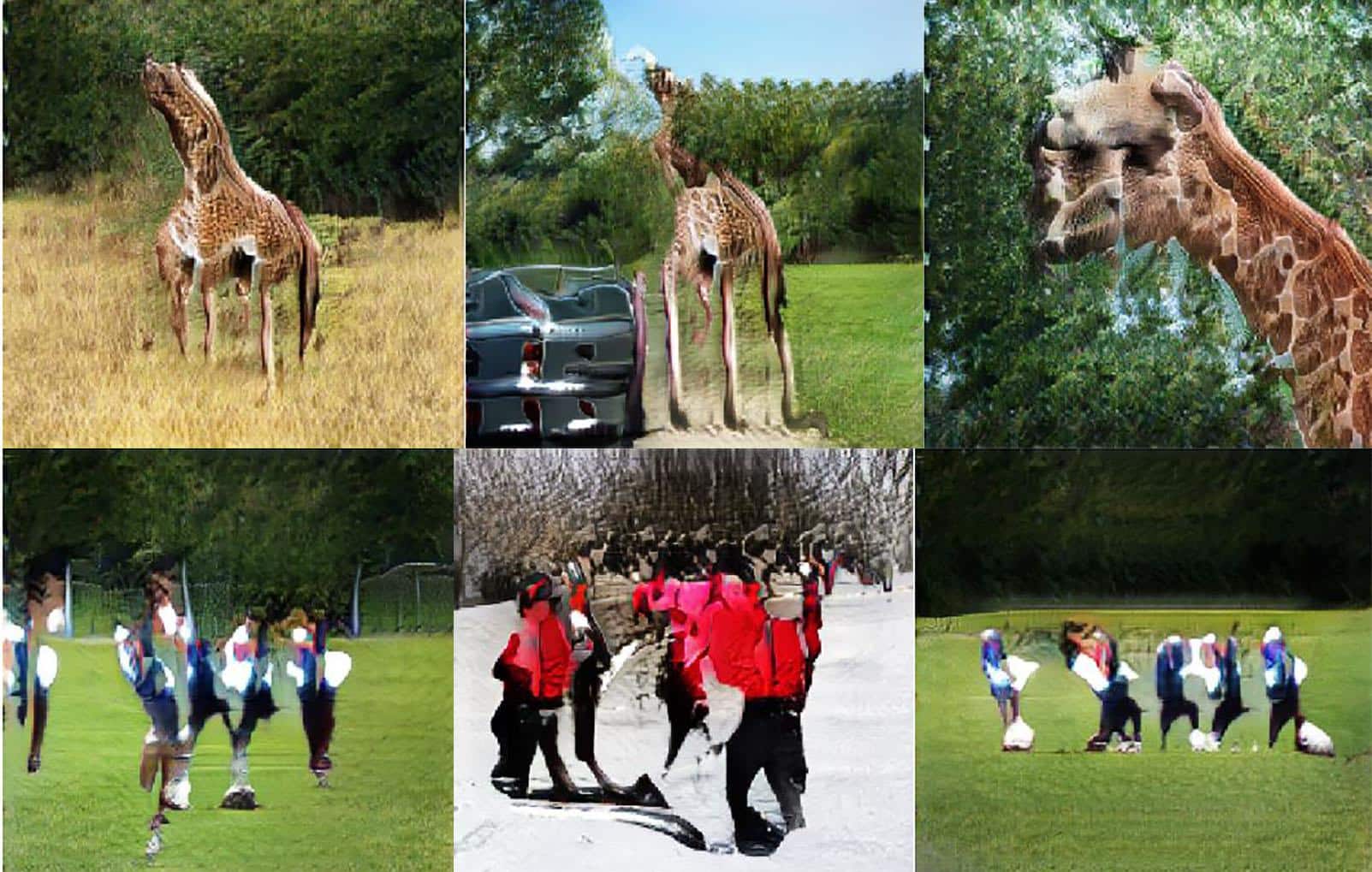

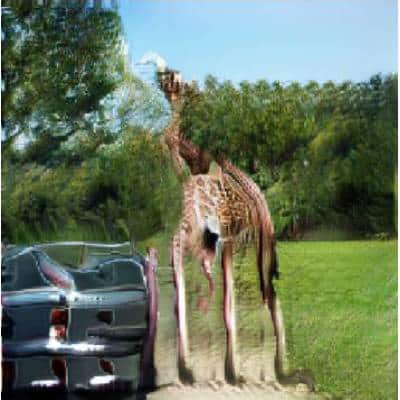

Por isso, o sistema precisa se basear em muito bom senso (e contexto) para preencher os detalhes. Quando o modelo (que pode ser testado aqui) recebe o comando de desenhar “uma girafa caminhando em uma estrada”, por exemplo, ele precisa inferir que a estrada é cinza, que o céu é azul e que há mais probabilidade de estar próxima a um gramado do que ao lado da água. E nenhuma dessas informações está na legenda.

“Uma girafa caminhando em uma estrada com dois carros se aproximando”. Imagem: Allen Institute for Artificial Intelligence/Reprodução

Apesar das imagens finais geradas pelo modelo não serem exatamente realistas, o projeto mostra que o sistema é capaz de um certo nível de abstração – como uma criança que desenha uma figura de palitos para representar um humano. A longo prazo, isso pode levar a robôs que compreendem seus arredores e usam linguagem para se comunicar sobre eles.