O futuro da inteligência artificial costuma ser um assunto polêmico. Empresas como Google, Facebook e Microsoft investem pesado em evoluir a capacidade de as máquinas pensarem. Do outro lado, há os que veem um risco sério na evolução desenfreada da IA, que poderia colocar em risco o futuro da humanidade; Stephen Hawking e Elon Musk, por exemplo, veem riscos sérios na prática.

Agora o Google decidiu tomar precauções para que as máquinas se rebelem. A DeepMind, adquirida pela companhia em 2014 e que se tornou seu braço de inteligência artificial, criou medidas de segurança para que operadores humanos possam, em caso de necessidade “tomar controle de um robô que não esteja se comportando e que possa causar consequências irreversíveis”.

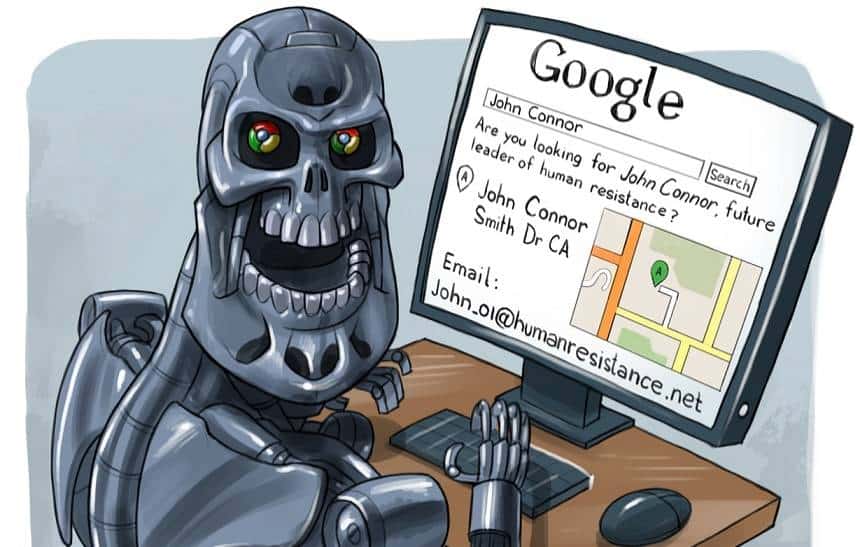

O artigo trata de casos mais mundanos de robótica, e não de cenários apocalípticos, como no filme “O Exterminador do Futuro”. Ele fala mais especificamente sobre robôs inteligentes trabalhando em uma fábrica, por exemplo, tratando do que poderia ser feito para desligar uma IA que começa a fazer algo que o operador não quer que ela faça, com métodos para criar um “botão vermelho” que encerre a atividade de uma máquina rebelde. Entre os objetivos do artigo está evitar que uma máquina criada para aprender aprenda a prevenir-se contra a interrupção causada por um humano.

O documento é fruto de um esforço em conjunto da DeepMind, do Google, e do Instituto do Futuro da Humanidade, da Universidade de Oxford. Como o nome do instituto deixa claro, seu objetivo é evitar que a inteligência artificial fique fora de controle ao ponto de se tornar um risco para a humanidade. O seu fundador, Nick Bostrom, tem feito bastante barulho sobre tais perigos, e já chegou a escrever livros sobre o tema dos robôs superinteligentes e suas implicações.

Por enquanto, porém, os riscos são baixos. As aplicações mais comuns de IA estão em serviços muito simples, como categorização de fotos do Facebook, e o feito mais impressionante do momento foi ter superado o campeão mundial do jogo de tabuleiro oriental Go. No entanto, Bostrom diz que o ritmo de evolução da IA tende a ser exponencial:

“Assim que a inteligência artificial atingir um nível humano, será possível criar um ciclo de feedback positivo que irá aumentar o ritmo de desenvolvimento. As IAs ajudariam a construir IAs melhores, que então ajudariam a criar IAs melhores, e assim por diante”.