Uma pesquisa recente do Facebook aplica modelos de aprendizado de máquina em tarefas que, para nós, parecem bastante comuns, mas para um computador ainda são muito difíceis. Esses projetos poderão anonimizar rostos, improvisar movimentos das mãos e até, quem sabe, dar conselhos de moda confiáveis.

A presente pesquisa foi apresentada recentemente na Conferência Internacional sobre Visão Computacional, entre algumas dezenas de outros artigos da empresa, que investiu pesadamente em pesquisa de IA e visão computacional, em particular.

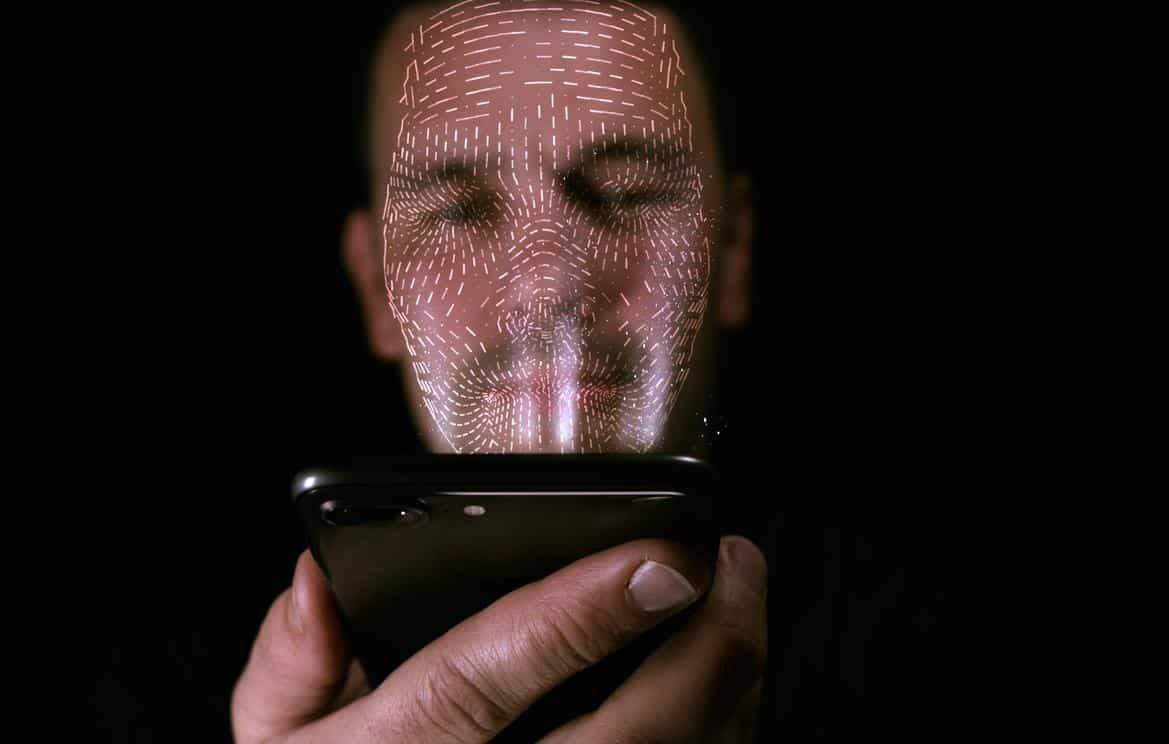

Modificar faces em movimento é algo que todos associamos a “deepfakes” e outras aplicações nefastas. Elas usam uma compreensão cuidadosamente cultivada dos recursos e pontos de referência do rosto para mapear as expressões e os movimentos de uma pessoa para um rosto completamente diferente.

O Facebook usou tais recursos e pontos de referência do rosto das pessoas para mapear suas expressões e movimentos. Essa tecnologia pode permitir, por exemplo, que alguém que não queira ser reconhecido publicamente apareça em um vídeo, sem precisar fazer uso de uma máscara ou um rosto completamente fabricado. As faces são levemente modificadas, tendo apenas olhos um pouco mais largos, boca mais fina, testa mais alta e outros pequenos detalhes.

De olho no não-verbal

O sistema parece funcionar bem, mas é claro que exigiria alguma otimização antes de poder ser implantado como um produto. O próximo passo da pesquisa é tentar capturar, catalogar e reproduzir gestos não-verbais dos seres humanos, ou pelo menos os que fazemos com as mãos. Para isso, os pesquisadores registraram 50 horas completas de duas pessoas tendo conversas o mais comum possível, usando equipamentos de captura de movimento de alta qualidade.

Essas conversas (relativamente) naturais e os movimentos do corpo e das mãos que as acompanham, foram ingeridos pelo modelo de aprendizado de máquina. Ele aprendeu a associar, por exemplo, que as pessoas apontavam para trás quando diziam “naquela época” ou faziam um gesto mais aberto ao dizer “em todo o lugar”.

No futuro, isso poderá ser utilizado para conversar e interagir em ambientes virtuais de uma forma mais natural. Mas a tecnologia também pode funcionar para o Fashion ++, um sistema que, após registrar uma grande biblioteca de imagens rotuladas como “roupas usadas por uma pessoa” (chapéu, cachecol, saia) e comparar com a moda geral (em medida subjetiva), pode sugerir dicas de moda.

No entanto, está longe de ser um assistente de moda digital, mas o documento fala do sucesso inicial de fazer sugestões de roupas que pessoas reais consideravam credíveis e talvez até uma boa ideia. Isso é impressionante, dado o quão complexo esse problema se mostra quando você realmente o considera e o quão mal definido é “moda”.

Fonte: TechCrunch