Deepfake é a nova sensação humorística que circula pela internet. Vídeos com os rostos de pessoas conhecidas pelo público, sejam engraçadas ou polêmicas, aparecem constantemente nas redes sociais. A princípio inofensiva, a prática já está sendo usada em pornografia e pode, em breve, ser utilizada como arma política.

Vídeos do presidente do Brasil, Jair Bolsonaro, e do ministro da Justiça, Sérgio Moro, com seus rostos em corpos de outros indivíduos ganharam destaque nos últimos meses. Os vídeos são produzidos pelo estudante Bruno Sartori, 30, que disse fazer sátiras sobre o governo atual. O jovem conseguiu, em curto período de tempo, obter até o momento 40 mil seguidores no Twitter, após as postagens.

O material audiovisual adulterado surgiu há cerca de dois anos e é feito por meio de inteligência artificial, que formata a face de uma pessoa no corpo de outra, com o intuito de simular uma ação do indivíduo (a qual ele nunca realizou). A frequência com que os vídeos falsos têm se alastrado para os confins da internet chama a atenção. Ao que tudo indica, as possibilidades do uso para o mal só tendem a crescer.

Anteriormente, graças à rapidez com que são propagadas informações na era digital, divulgar imagens íntimas sem a permissão do envolvido já causava um dano impactante em sua reputação. Agora, com o crescimento do deepfake, pode se tornar mais comum encontrar na internet vídeos pornôs falsos com rostos de políticos famosos, por exemplo. Isso é possível porque para adulterar um vídeo de alguém falando ou fazendo algo, basta pegar o material verdadeiro, coletar imagens suficientes do rosto da “vítima” e, usando um programa, criar o conteúdo falso com tais imagens.

Casos famosos

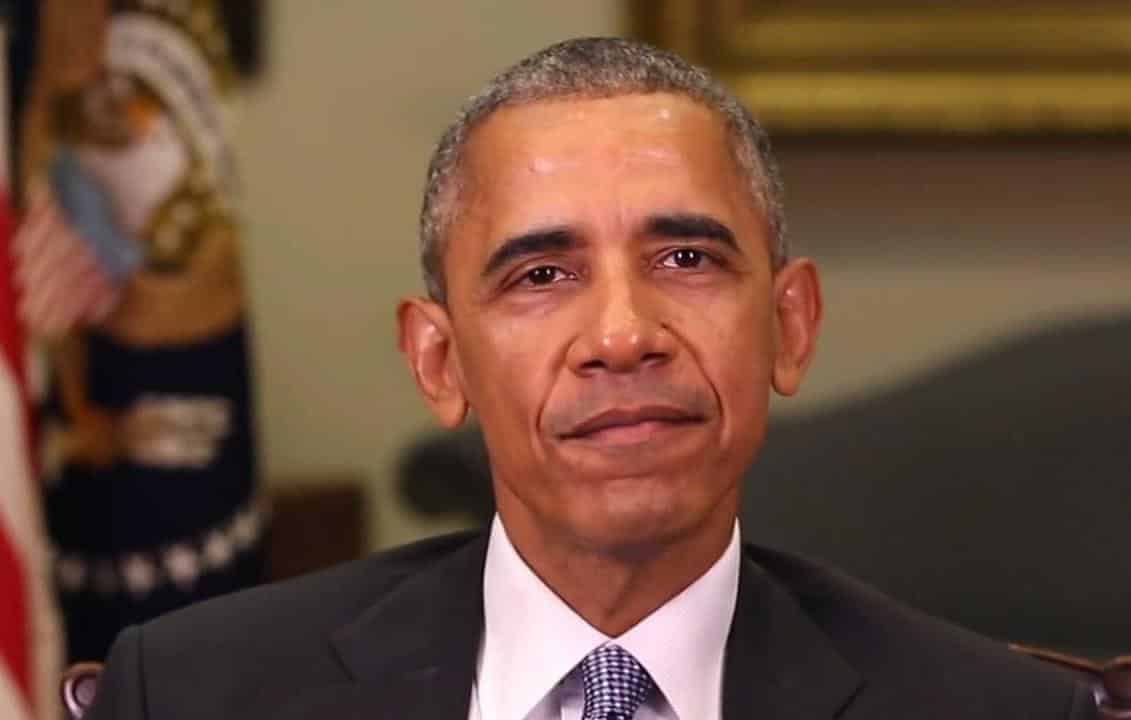

Um dos primeiros vídeos produzidos usando técnicas de deepfake e que ficou conhecido mundialmente foi publicado no ano passado, no qual mostra o ex-presidente dos EUA Barack Obama proferindo xingamentos contra o atual presidente Donald Trump, o que causou indignação entre os seguidores do presidente norte-americano.

No Brasil, um caso que ficou muito conhecido ano passado foi o “pornô” do então prefeito de São Paulo, João Dória. Quando o vídeo foi divulgado, Dória estava no meio da campanha para concorrer a governador do estado, o que possivelmente afetou sua popularidade. Apesar de algumas pessoas confirmarem que o vídeo é falso, a perícia não foi unânime em sua decisão.

Já na pornografia, um usuário anônimo disponibilizou em um fórum código que criava imagens falsas a partir de vídeos reais disponíveis na internet e, para demonstrar como usá-lo, produziu vídeos pornográficos com rostos de atrizes famosas, como Scarlett Johansson e Emma Stone.

Medidas

No fim do ano passado, logo após o caso Dória, o Código Penal brasileiro sofreu uma alteração que incluiu no seu rol de crimes o ato de produzir, fotografar, filmar ou registrar qualquer meio ou conteúdo com cenas de nudez ou ato sexual sem autorização dos participantes.

“O legislador brasileiro vai ser confrontado com essas situações. Eu não acho que precisa de uma lei específica. Só acho que no Código Penal, o artigo criado no final do ano passado é específico para sexo e nudez. Tudo o que não cai nele terá que ser trabalhado como direito à imagem, à honra, que já estão previstos no ordenamento jurídico brasileiro”, afirmou Carlos Affonso, diretor do ITS (Instituto de Tecnologia e Sociedade) e professor da UERJ.

Os Estados Unidos, cientes da nova realidade, incluíram na lei contra pornografia de vingança (que vigora desde 2014) o termo deepfake, como tentativa de cercear a prática no país. Além de casos de pornografia e alteração em corridas eleitorais, criminosos têm usado as técnicas de modificação audiovisual para se passar por executivos de grandes empresas e, assim, conseguir com que sejam efetuadas transferências bancárias.

A Symantec, empresa norte-americana que atua em segurança na internet, informou à BBC em julho que já tomou conhecimento de ao menos três casos de áudios produzidos por pessoas que tentaram se passar por diretores de empresas para roubar dinheiro.

Fake ou não?

Descobrir se um vídeo é verdadeiro ou falso não é uma tarefa fácil. Segundo Affonso, até mesmo peritos têm dificuldade em identificar a veracidade deles. O professor usou o caso Dória como exemplo para mostrar a complexidade do deepfake.

“Na semana em que o vídeo foi divulgado, tiveram dois laudos periciais contraditórios. Um que dizia que havia a adulteração e outro que dizia que não havia. Isso mostra como essa manipulação requer uma sofisticação e pode ser desafiadora até mesmo para uma prova pericial”, disse.

Com o surto das fake news e o avanço do deepfake, o principal desafio, segundo Affonso, será o de conscientizar as pessoas sobre uma nova cultura de como nos relacionamos com o conteúdo audiovisual. “É preciso gerar essa percepção, que está longe de estar disseminada na sociedade como um todo, de que o vídeo também pode ser facilmente manipulável”, concluiu.

Via: Uol